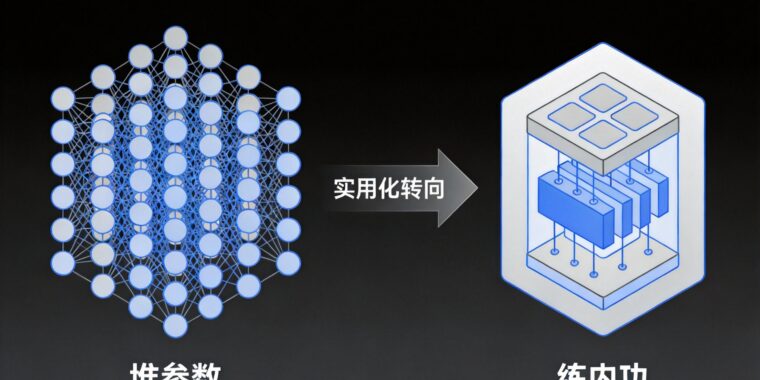

当我们还在惊叹大模型参数突破万亿的震撼时,2026年的AI赛道已经悄然换了赛道。近期多项行业资讯显示,大模型技术正从”追求规模”的狂热,转向”打磨内功”的务实,一场围绕效率、可靠性与落地能力的技术竞赛正全面展开。

从”炫技”到”解决问题”的思路转变

过去几年,大模型的发展关键词是”更大”——参数规模从十亿级跃升至万亿级,似乎参数越多,模型就越智能。但如今,行业的注意力开始聚焦于”更好用”。腾讯云发布的LLM进阶指南中,思维链推理、结构化提示工程等技术,能将模型幻觉率降低70%,这比单纯提升参数规模更能解决企业的实际痛点。毕竟,对于金融、医疗等领域的用户来说,可靠的答案远比华丽的生成更重要。

架构创新破解效率瓶颈

大模型的”效率焦虑”正在被新的架构方案缓解。外刊预测的2026年8大技术路线中,Transformer与状态空间模型(SSM)的混合架构成为焦点,这种结合能将注意力机制的二次方复杂度降为线性,让长上下文处理不再是奢望。而混合专家(MoE)架构的普及,更是在2025年就展现出威力——CSDN的年度技术总结显示,MoE让模型在保持大能力的同时,训练和推理成本大幅降低,为企业级应用扫清了成本障碍。

多模态从”可选”变”标配”

如果说2024年多模态还是大模型的”加分项”,2025年它已经成为了”入门券”。从拼接式架构到原生多模态的演进,让AI真正具备了”全感官”能力:不仅能读文本,还能看图像、听音频、理解视频信号。这种转变让大模型的应用场景得到爆发式拓展——从工业质检的图像分析,到智能座舱的多模态交互,AI终于能像人类一样,在复杂的真实世界中处理信息。

智能体让大模型”动起来”

技术的最终价值在于落地,而AI Agent正是连接大模型能力与实际任务的桥梁。2025年智能体的商业化爆发,让大模型从”会说话的知识库”变成了”能干活的数字员工”。结合思维链推理的复杂问题拆解能力,智能体可以自主完成从需求分析到任务执行的全流程,比如自动生成营销方案、处理客户服务工单,甚至协助完成复杂的科研数据整理。

落地时代的新挑战

当然,大模型的实用化转型也带来了新的挑战。如何在提升效率的同时保证模型的可靠性?多模态融合中的数据对齐问题如何解决?边缘部署的安全隐患又该如何防范?这些问题不再是实验室里的理论探讨,而是企业落地AI时必须直面的现实。

从参数竞赛到能力深耕,大模型正在从”技术奇观”走向”实用工具”。2026年,那些能真正解决行业痛点、兼顾效率与可靠性的技术,将成为推动AI产业发展的核心动力。对于企业和开发者来说,读懂这场转向,才能在AI的下一个阶段抢占先机。